AI 视频,死于 3 秒

一个残酷的真相:你的AI视频越完美,死得越快。

现在的 TikTok,流量早就不奖励谁更勤奋,而是在筛选谁更接近真实需求,前 3 秒,算法就做了选择。

你精心打磨的 4K 画质、炫技式转场、对齐到像素级的构图,在用户眼里,并不是加分项,只是更精致一点的“广告感”。

而广告感,是最容易被跳过的东西。用户甚至还没看清你在卖什么,手指已经划走了。

更讽刺的是,AI并不是不想像人,它是太用力地在模仿人。越想把画面做“高级”,越容易暴露出那种塑料感。

这也是为什么现在真正能跑出来的素材,反而都带着一点“不讲究”。

如果你发现自己的AI视频总是:

画面没问题、逻辑没问题、但就是没转化,那问题很可能不在工具,而在你一开始就把AI“教错了”。

接下来要讲的,不是怎么把视频做得更漂亮,

而是怎么通过提示词和结构设置,让AI生成的内容,正是这些“不完美”,才是真正被算法和用户同时接受的部分。

1. 越少,越稳

很多人写提示词的时候,恨不得把所有细节一次性交代清楚,生怕AI“理解错”。

结果往往相反:指令越多,画面越乱。

实战里更有效的做法是抓大放小。

只给核心场景、核心动作,其余的交给模型自己补全。

从数据看,高转化的视频结构都非常简单。

原因也不复杂:指令一旦变复杂,AI更容易在动作上出问题,反而显得不真实。

2. 反常识,才像生活

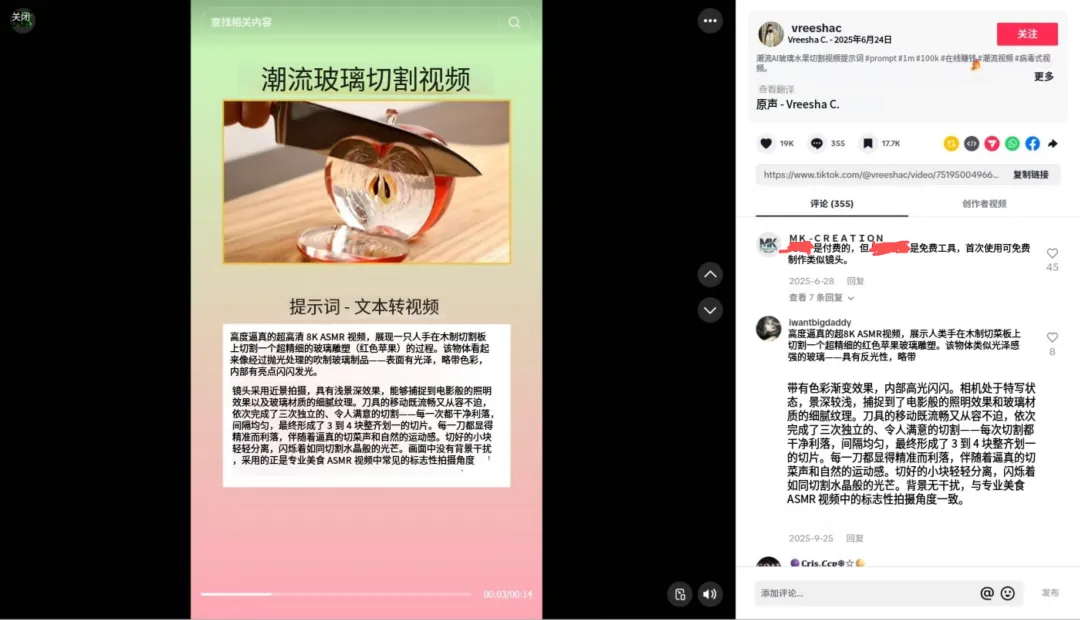

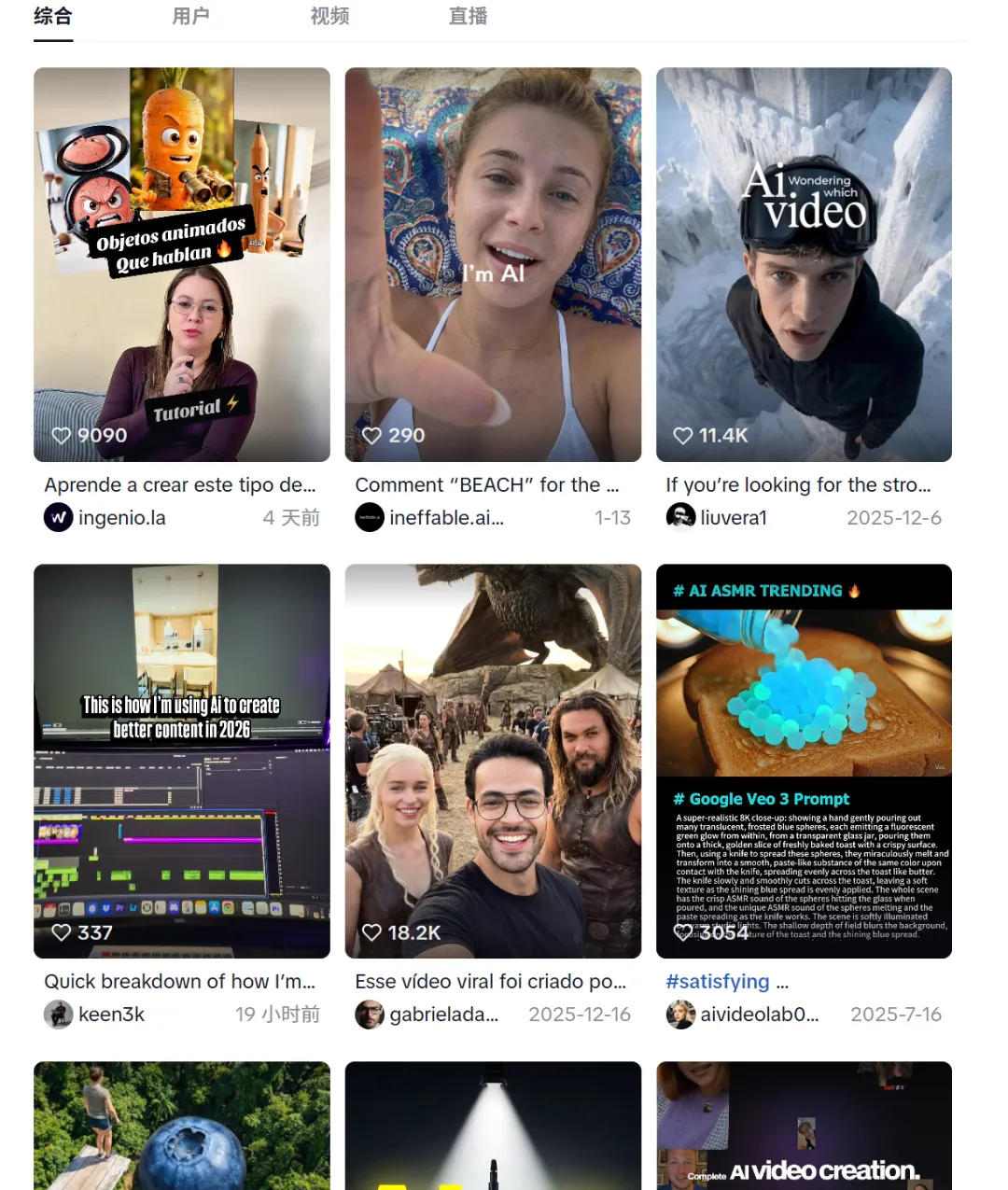

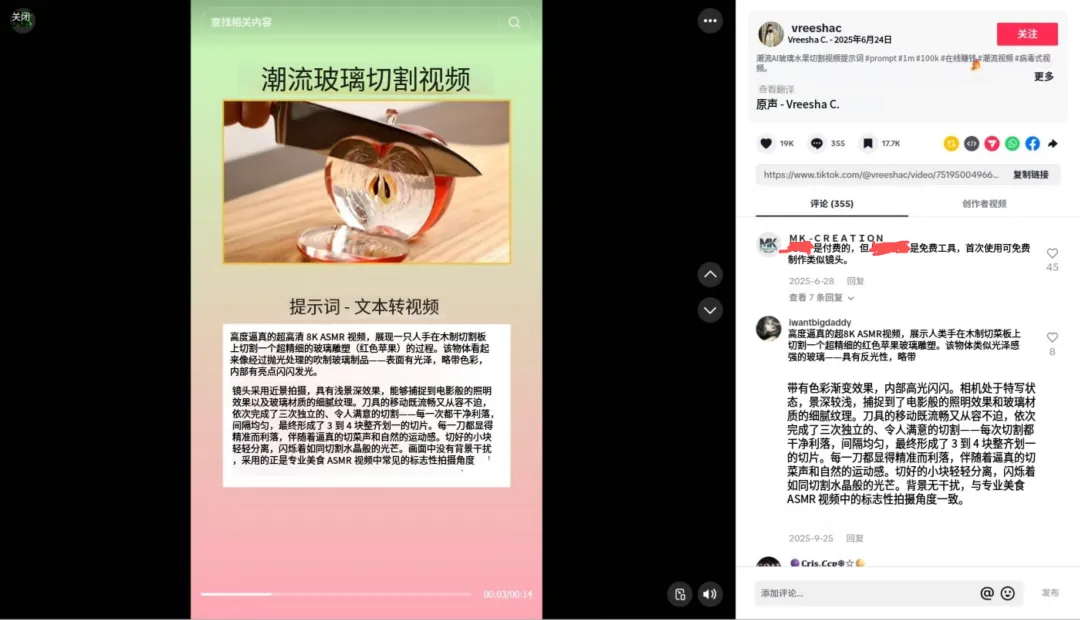

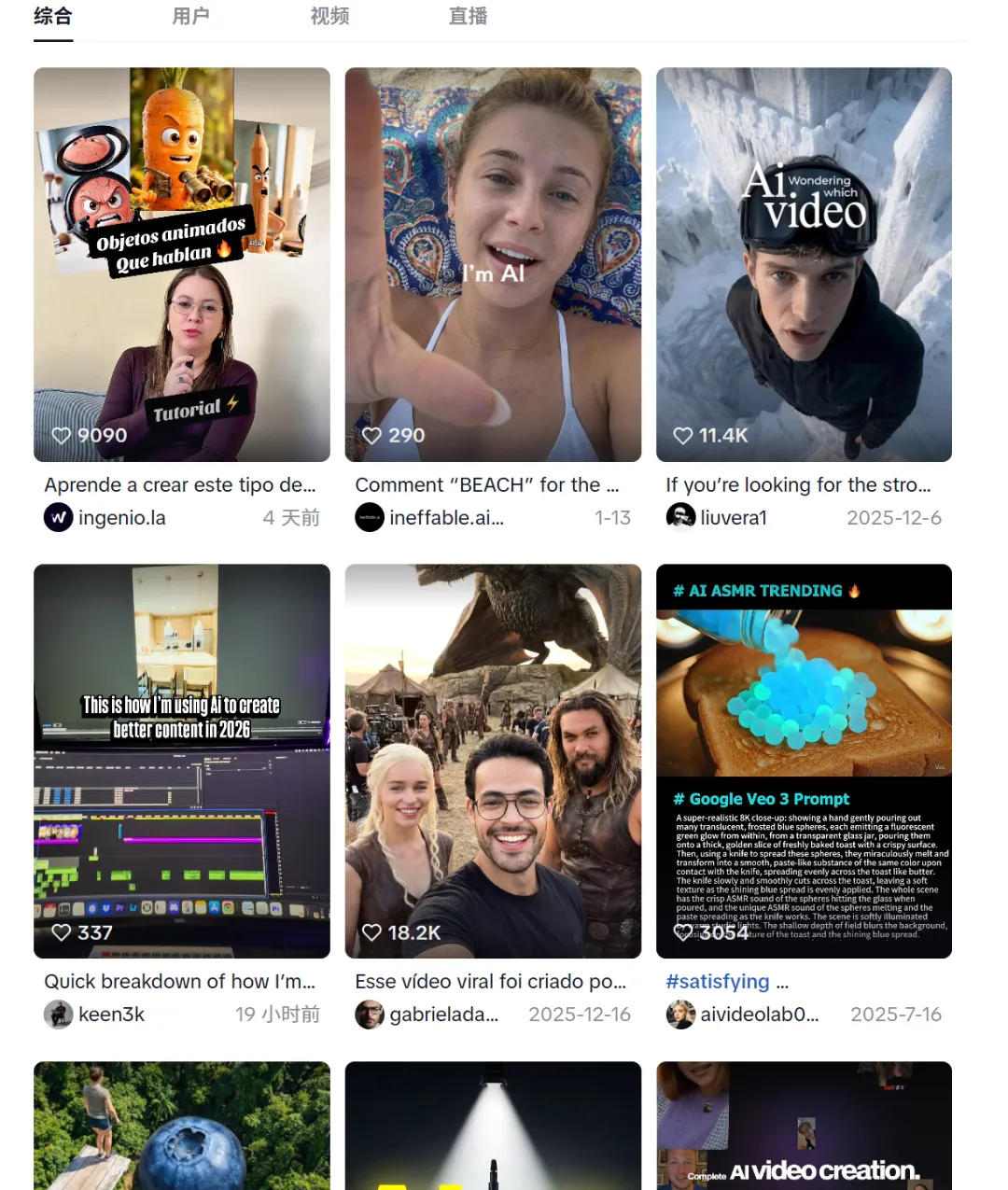

点击查看 TikTok 热门 AI 提示词教程视频

这是最容易翻车的一步,很多人会写:“光线充足”“阳光明媚”。

AI 给你的,通常是一整套均匀、干净、毫无情绪的“样板光”。

但真实生活不是这样的。

在 EchoTik 的实操里,更有效的反而是:阴天、昏暗、室内夜晚。

低曝光的画面,会自然出现光线不均匀,模糊颗粒,这些“不完美”的细节,恰恰是用户熟悉的日常。

它们会让人下意识放松警惕,觉得这是“真的有人在拍”。

3. 别用虚词,直接点名

“4K、8K、超清”这种词,对AI来说意义不大。

它只会帮你把画面磨得更假。

更有效的方式,是直接指定设备型号。

比如:“拍摄设备:iPhone 14”。

原因很简单:模型的训练数据里,本来就有大量手机实拍素材。

当你点名具体设备,它会自动模仿手机的拍照效果,包括画面会有一点点颗粒感、边缘不会过于清晰刺眼,不过度锐化。

这种画质,才更容易被当成“真人拍的”。

4. 别卡时间,卡逻辑

很多“穿模”“鬼畜动作”,其实都是人为制造的。

比如强行规定:“0–3秒完成拿取动作”。

AI为了赶时间,只能压缩动作过程,最后看起来就像瞬移。

更稳妥的方式,是拆场景,不限时长:

场景1:人物拿起产品

场景2:人物展示产品

让AI自己分配节奏,它生成的动作反而更符合现实的物理逻辑,也更耐看。

很多人觉得AI视频跑不动,是工具不行。但更多时候,问题出在审美本身就歪了。

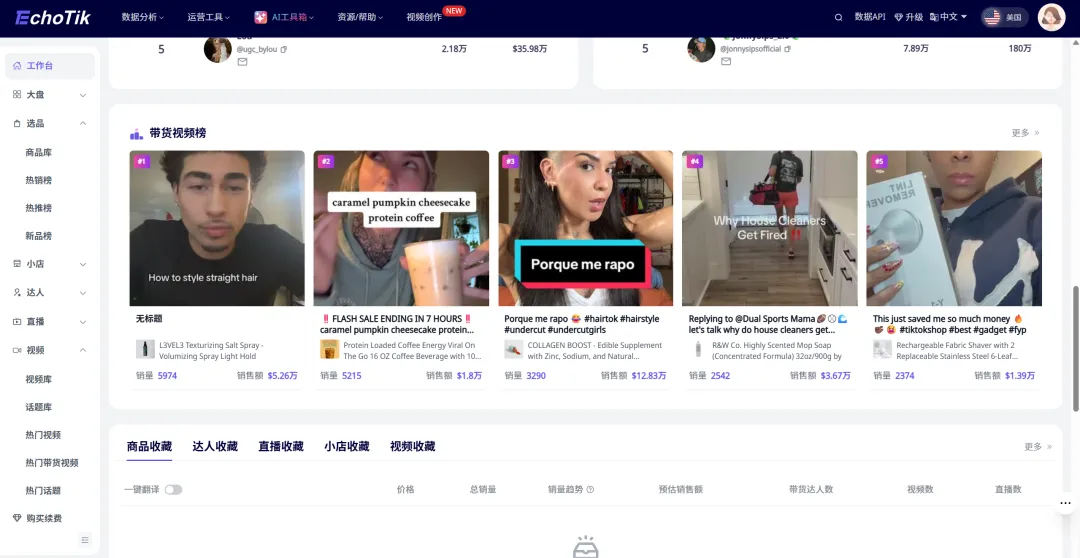

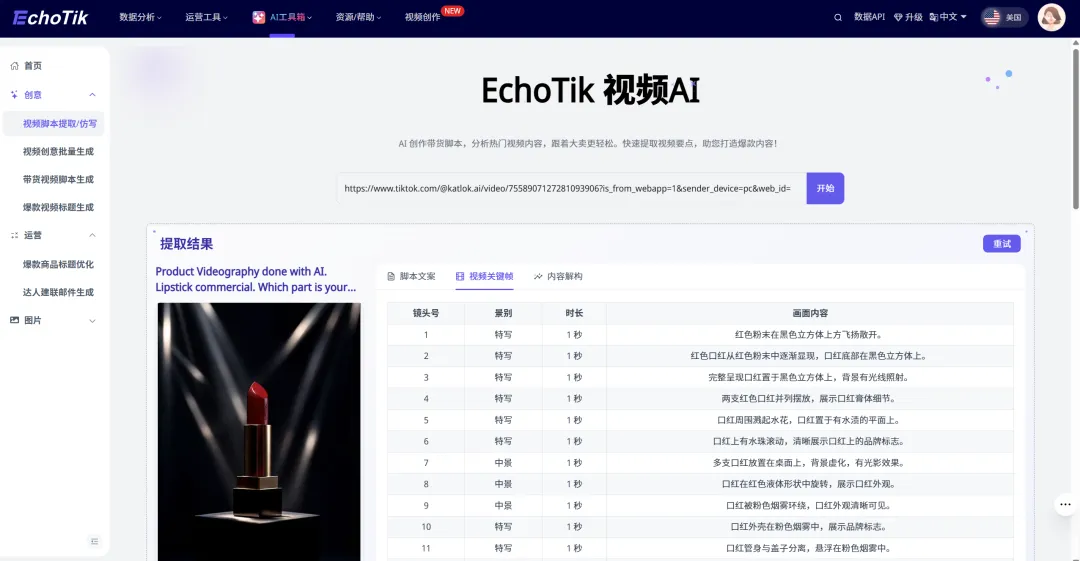

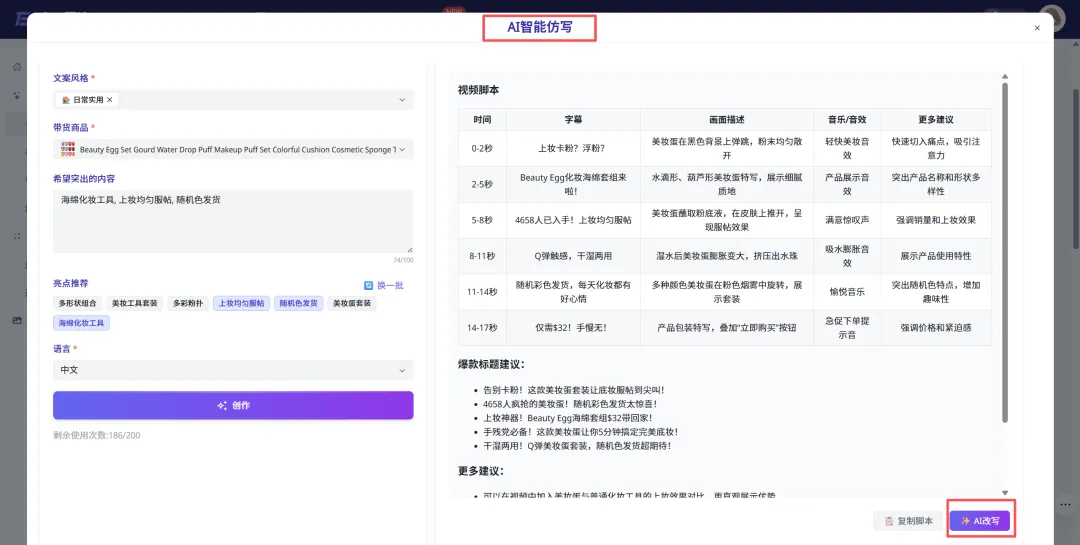

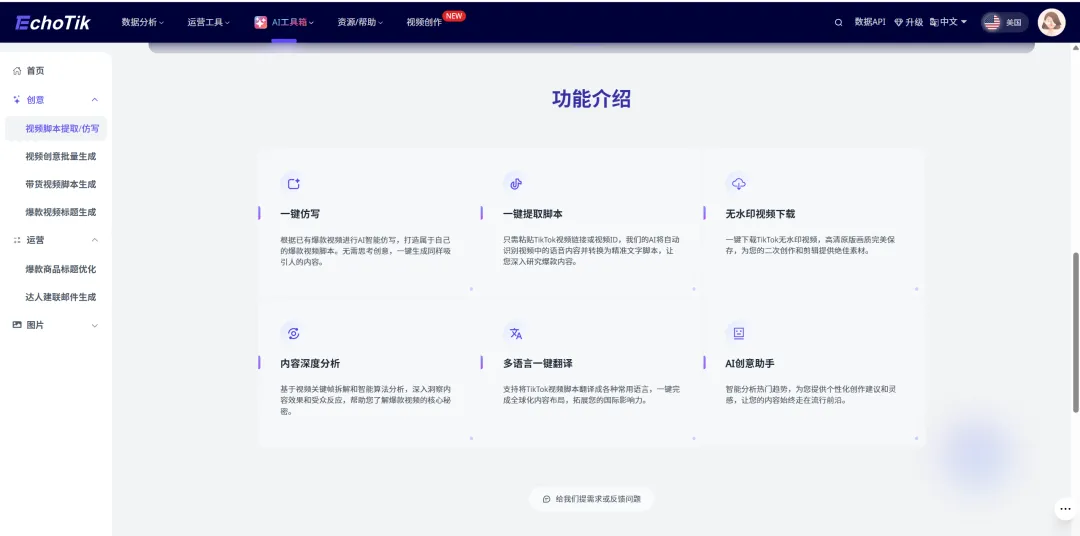

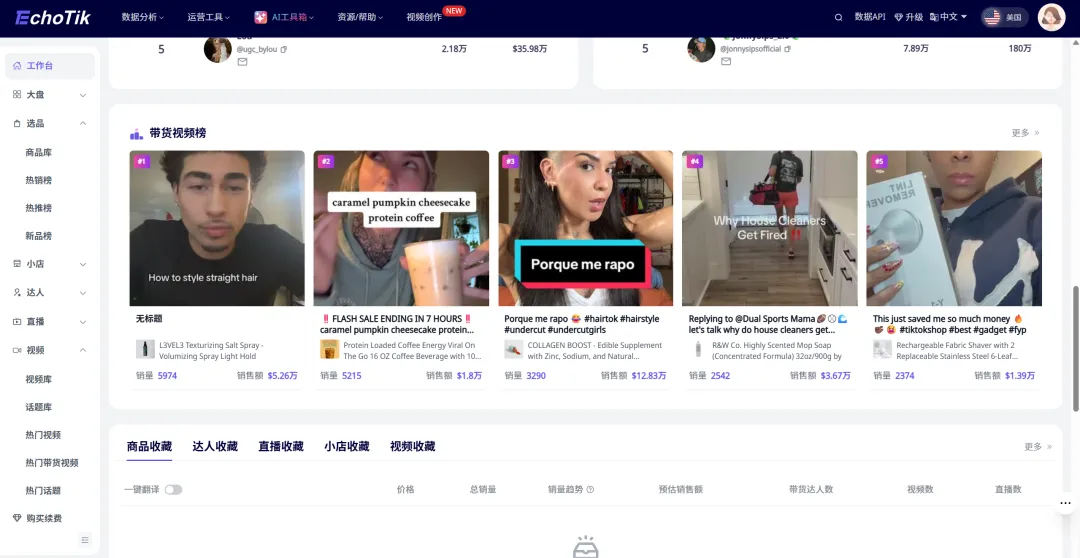

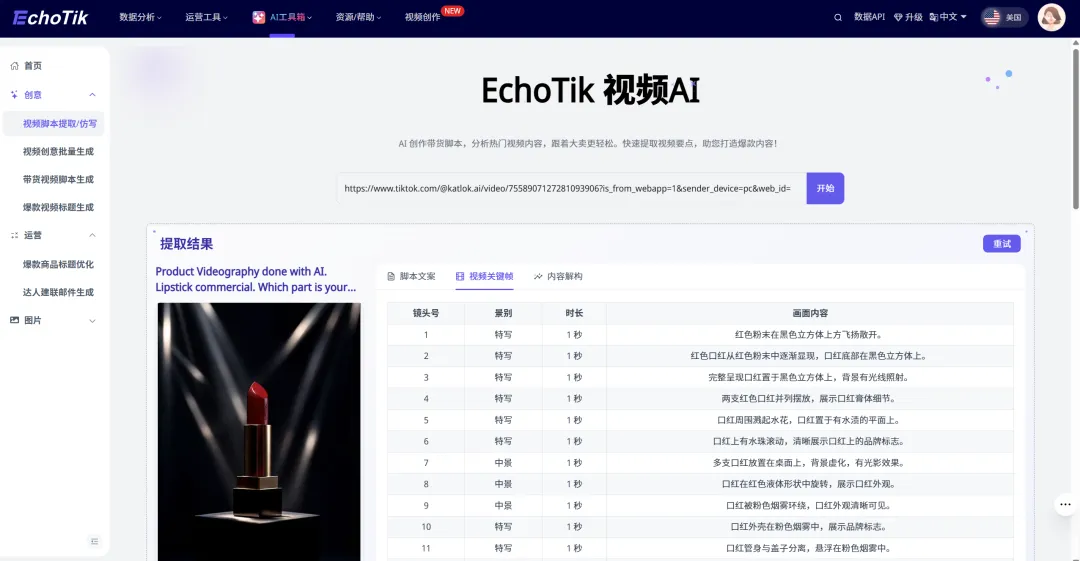

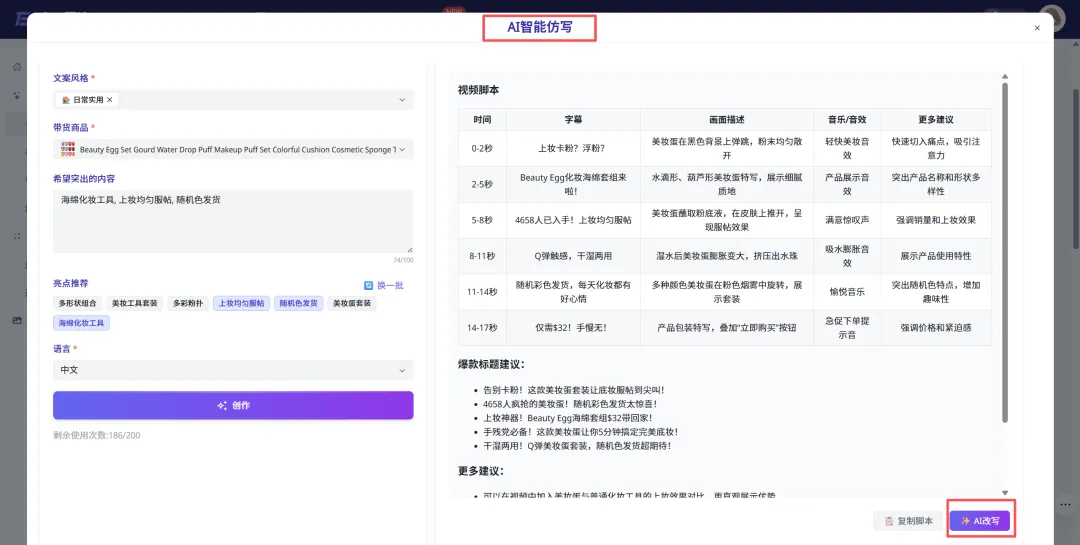

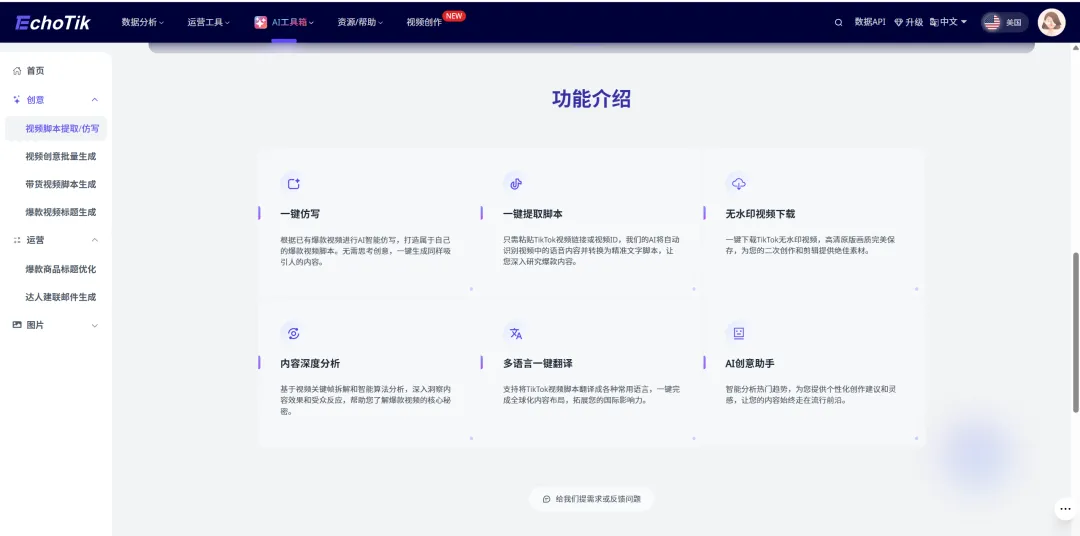

EchoTik 的价值,并不是“给你素材”,而是帮你回答一个更重要的问题:

现在,什么样的“不完美”正在出单?是光线偏暗的开箱?还是手机质感的测评?

当你把这些共性拆出来,再用前面提到的方式去复现,本质上是在做一件事:

用数据验证结构,而不是凭感觉碰运气。

当下这个阶段,AI视频的门槛已经低到不能再低了。

当所有人都能一键生成内容时,“量”本身已经没有溢价。真正拉开差距的,反而是克制。

是你愿不愿意接受一点不完美,给画面留一点呼吸空间。AI只是工具,数据才是方向盘。

与其不断追求让它更“高级”,不如研究怎么让它更像一个普通人。

在这个被算法填满的环境里,真实,已经成了一种成本极高的东西。

至于要不要把画面做得“丑”一点,这其实是个判断题,不是技巧题。

一个残酷的真相:你的AI视频越完美,死得越快。

现在的 TikTok,流量早就不奖励谁更勤奋,而是在筛选谁更接近真实需求,前 3 秒,算法就做了选择。

你精心打磨的 4K 画质、炫技式转场、对齐到像素级的构图,在用户眼里,并不是加分项,只是更精致一点的“广告感”。

而广告感,是最容易被跳过的东西。用户甚至还没看清你在卖什么,手指已经划走了。

更讽刺的是,AI并不是不想像人,它是太用力地在模仿人。越想把画面做“高级”,越容易暴露出那种塑料感。

这也是为什么现在真正能跑出来的素材,反而都带着一点“不讲究”。

如果你发现自己的AI视频总是:

画面没问题、逻辑没问题、但就是没转化,那问题很可能不在工具,而在你一开始就把AI“教错了”。

接下来要讲的,不是怎么把视频做得更漂亮,

而是怎么通过提示词和结构设置,让AI生成的内容,正是这些“不完美”,才是真正被算法和用户同时接受的部分。

1. 越少,越稳

很多人写提示词的时候,恨不得把所有细节一次性交代清楚,生怕AI“理解错”。

结果往往相反:指令越多,画面越乱。

实战里更有效的做法是抓大放小。

只给核心场景、核心动作,其余的交给模型自己补全。

从数据看,高转化的视频结构都非常简单。

原因也不复杂:指令一旦变复杂,AI更容易在动作上出问题,反而显得不真实。

2. 反常识,才像生活

点击查看 TikTok 热门 AI 提示词教程视频

这是最容易翻车的一步,很多人会写:“光线充足”“阳光明媚”。

AI 给你的,通常是一整套均匀、干净、毫无情绪的“样板光”。

但真实生活不是这样的。

在 EchoTik 的实操里,更有效的反而是:阴天、昏暗、室内夜晚。

低曝光的画面,会自然出现光线不均匀,模糊颗粒,这些“不完美”的细节,恰恰是用户熟悉的日常。

它们会让人下意识放松警惕,觉得这是“真的有人在拍”。

3. 别用虚词,直接点名

“4K、8K、超清”这种词,对AI来说意义不大。

它只会帮你把画面磨得更假。

更有效的方式,是直接指定设备型号。

比如:“拍摄设备:iPhone 14”。

原因很简单:模型的训练数据里,本来就有大量手机实拍素材。

当你点名具体设备,它会自动模仿手机的拍照效果,包括画面会有一点点颗粒感、边缘不会过于清晰刺眼,不过度锐化。

这种画质,才更容易被当成“真人拍的”。

4. 别卡时间,卡逻辑

很多“穿模”“鬼畜动作”,其实都是人为制造的。

比如强行规定:“0–3秒完成拿取动作”。

AI为了赶时间,只能压缩动作过程,最后看起来就像瞬移。

更稳妥的方式,是拆场景,不限时长:

场景1:人物拿起产品

场景2:人物展示产品

让AI自己分配节奏,它生成的动作反而更符合现实的物理逻辑,也更耐看。

很多人觉得AI视频跑不动,是工具不行。但更多时候,问题出在审美本身就歪了。

EchoTik 的价值,并不是“给你素材”,而是帮你回答一个更重要的问题:

现在,什么样的“不完美”正在出单?是光线偏暗的开箱?还是手机质感的测评?

当你把这些共性拆出来,再用前面提到的方式去复现,本质上是在做一件事:

用数据验证结构,而不是凭感觉碰运气。

当下这个阶段,AI视频的门槛已经低到不能再低了。

当所有人都能一键生成内容时,“量”本身已经没有溢价。真正拉开差距的,反而是克制。

是你愿不愿意接受一点不完美,给画面留一点呼吸空间。AI只是工具,数据才是方向盘。

与其不断追求让它更“高级”,不如研究怎么让它更像一个普通人。

在这个被算法填满的环境里,真实,已经成了一种成本极高的东西。

至于要不要把画面做得“丑”一点,这其实是个判断题,不是技巧题。

热门活动

热门活动

浙江

浙江 03-20 周五

03-20 周五